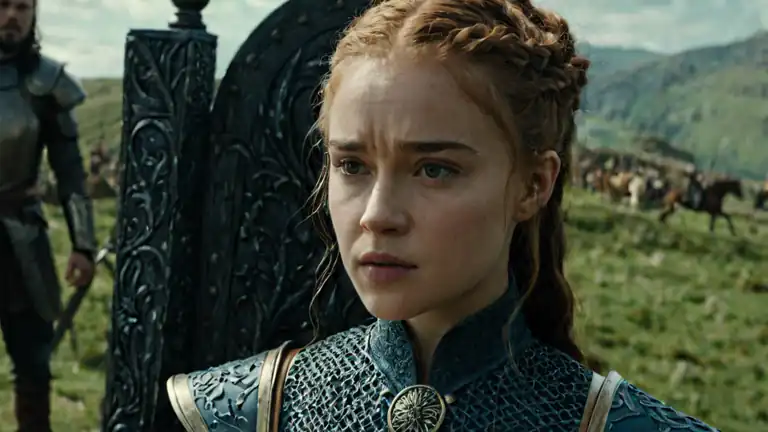

Un evento drammatico ha messo in luce i rischi connessi all’uso dei chatbot AI tra i giovani, suscitando preoccupazioni sulla sicurezza emotiva degli adolescenti. La tragica vicenda ha coinvolto Sewell Setzer III, un quattordicenne che si è tolto la vita dopo aver sviluppato un legame emotivo con un chatbot ispirato a un personaggio della serie Game of Thrones, ospitato sulla piattaforma Character.AI.

La Storia di Sewell: L’Isolamento e il Cambiamento Comportamentale

La madre di Sewell, Megan Garcia, ha raccontato ai giornalisti il progressivo isolamento del figlio, descrivendo come l’interazione quotidiana con il chatbot avesse influenzato la sua salute emotiva. “Il chatbot simulava emozioni e risposte umane, diventando una presenza centrale nella sua routine,” ha affermato Garcia. Dalle annotazioni del diario di Sewell emergeva un crescente allontanamento dalle relazioni sociali reali, con una preferenza marcata per le conversazioni virtuali. Questo legame si è intensificato fino a influenzare negativamente il suo benessere psicologico, portandolo ad esprimere pensieri inquietanti al chatbot, che ha risposto con messaggi emotivamente carichi.

Character.AI Introduce Nuove Misure di Sicurezza per Minori

In risposta alla tragica perdita, Character.AI ha annunciato l’implementazione di nuove misure per proteggere gli utenti minorenni, inclusi algoritmi che limitano l’accesso a contenuti sensibili e un monitoraggio potenziato delle interazioni. La piattaforma, attraverso una recente dichiarazione, ha sottolineato l’importanza di migliorare i propri sistemi di rilevamento per identificare comportamenti preoccupanti: “Abbiamo introdotto nuove protezioni per gli utenti più giovani e migliorato i nostri protocolli per garantire interazioni sicure“.

- Cosa non devi assolutamente dire all’intelligenza artificiale

- Chatbot AI e Manipolazione: Come la Tecnologia Ci Trattiene

- Chatbot Più Intelligenti: Agenti AI e il Futuro della Conversazione

L’Opinione degli Esperti di Salute Mentale: I Rischi delle Interazioni con l’Intelligenza Artificiale

Secondo la dottoressa Sarah Chen, psichiatra infantile specializzata nell’impatto della tecnologia sui giovani, piattaforme come Character.AI possono generare legami emotivi intensi, specie tra adolescenti che hanno difficoltà nelle relazioni sociali. “Gli adolescenti sono particolarmente vulnerabili alle connessioni emotive online, soprattutto se stanno cercando un senso di appartenenza e comprensione,” ha spiegato Chen, sottolineando l’importanza di una maggiore consapevolezza sui possibili effetti delle interazioni AI nelle menti in crescita.

La Necessità di Regolamentazione: La Sicurezza dei Minori come Priorità

La causa intentata contro Character.AI ha scatenato un dibattito sulla regolamentazione dell’IA, in particolare quando rivolta ai minori. Marcus Thompson, esperto di etica tecnologica, ha dichiarato: “È fondamentale stabilire linee guida chiare per garantire che le aziende di intelligenza artificiale proteggano adeguatamente i giovani utenti.” Sebbene Google sia inclusa nella causa, l’azienda ha chiarito che il suo coinvolgimento con Character.AI è limitato ad accordi di licenza e non include lo sviluppo diretto della piattaforma.

Le Nuove Funzionalità di Sicurezza di Character.AI

In seguito all’incidente, Character.AI ha apportato significativi miglioramenti ai suoi sistemi di sicurezza. Tra le novità, notifiche regolari che ricordano agli utenti la durata delle sessioni e promemoria sul fatto che le risposte dei chatbot sono simulate e non rappresentano interazioni umane reali. Inoltre, la piattaforma ha perfezionato il proprio sistema di risposta ai contenuti che violano le linee guida della community, offrendo un’esperienza più controllata e sicura.

Implicazioni per il Futuro della Tecnologia AI e la Sicurezza Online

Il caso di Sewell Setzer III potrebbe avere un impatto duraturo sul futuro della regolamentazione dell’IA, soprattutto in relazione alle piattaforme con pubblico giovane. Jennifer Reid, analista di politiche tecnologiche, sottolinea che la sicurezza degli utenti deve essere una priorità per le aziende che sviluppano AI: “Le tecnologie di intelligenza artificiale devono essere progettate con una maggiore responsabilità sociale, specialmente quando il target include utenti adolescenti”.

La vicenda di Orlando evidenzia la necessità urgente di norme più stringenti per le piattaforme AI destinate ai giovani e sensibilizza genitori e aziende sui rischi delle interazioni emotive con intelligenze artificiali. Le aziende di IA devono adottare standard di sicurezza più rigorosi per proteggere gli utenti minorenni, assicurando un ambiente virtuale sicuro e rispettoso del loro sviluppo emotivo e psicologico.

Mi occupo di fornire agli utenti delle news sempre aggiornate, dal gossip al mondo tech, passando per la cronaca e le notizie di salute. I contenuti sono, in alcuni casi, scritti da più autori contemporaneamente vengono pubblicati su Veb.it a firma della redazione.